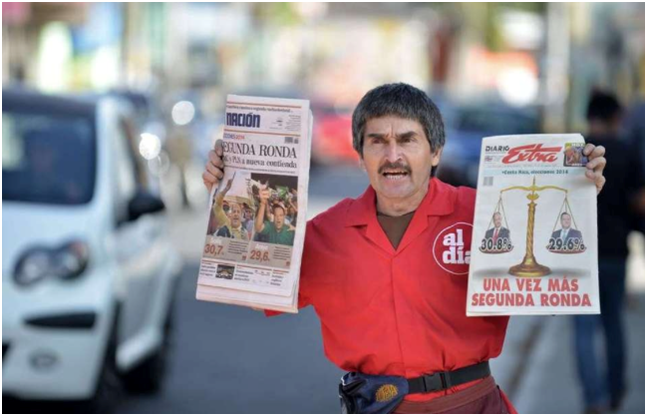

A propósito de las elecciones presidenciales en Costa Rica mucho se han criticado las diferencias entre los resultados de las encuestas y resultado real de la votación. Aunque mi campo de acción es mucho más la estadística industrial que la estadística social, quiero tratar esta semana el tema del proceso electoral desde un punto de vista matemático, sin “embarrialarme” en el campo político.

MUY BREVE HISTORIA DE LOS PRONÓSTICOS Y LAS ENCUESTAS DE OPINIÓN

Desde siempre han existido los oráculos y las profecías, aunque los resultados de este tipo de predicción nunca fueron ni son confiables. Los antiguos egipcios estimaban sus cosechas con base en el nivel del río Nilo en la temporada de inundaciones. En el siglo XVII Sir William Petty creo un sistema de pronósticos de negocios basado en ciclos de siete años. En 1909 Roger Babson publica el libro Business Barometers for Anticipating Conditions (Barómetros de Negocios para Anticipar Condiciones) basado en el método personal que le había permitido amasar gran fortuna. Según Babson si las condiciones permanecen estables es posible utilizar datos estadísticos para estimar las condiciones futuras del mercado. En 1930 estalla la Gran Depresión. A pesar de que la incipiente ciencia de la predicción estadística ya rondaba los 20 años, ningún experto, ningún método, ni ninguna técnica anticiparon la debacle económica. Después de la Segunda Guerra Mundial se hicieron comunes las predicciones macroeconómicas basadas, sobre todo en bases Keynesianas.

La primera encuesta de opinión la realizó el periódico The Harrisburg Pennsylvanian en 1824, e indicaba el triunfo de Andrew Jackson sobre John Quincy Adams por 355 contra 169 votos en la lucha por la presidencia de los Estados Unidos. Dada al coincidencia de la pequeña muestra con el resultado real las encuestas de opinión se hicieron muy populares. La desaparecida revista de interés general The Literary Digest realizó la primera encuesta de opinión de alcance nacional en los Estados Unidos y en 1916 predijo correctamente el triunfo de Woodrow Wilson en las elecciones presidenciales de ese país. Usando el mismo método la revista predijo correctamente los triunfos de Harding en 1920, Coolidge en 1924, Hoover en 1928 y Roosevelt en 1932. Pero en 1936 debido a errores en la estratificación de su muestra la revista predijo, equivocadamente, el triunfo del republicano Alf Landon. Un nuevo método más científico, basado en una muestra mucho más pequeña pero mejor diseñada, le permitió a George Gallup predecir la victoria de Roosevelt sobre Landon. Los métodos de Gallup se establecieron como la base del análisis de encuestas por muchos años.

LA ENCUESTA TRADICIONAL ANTE INCERTIDUMBRE, ERRORES DE PERCEPCIÓN Y COMPLEJIDAD

Las empresas encuestadoras serias, establecidas hace muchos años y muy profesionales utilizan correctamente las herramientas de diseño, aplicación, procesamiento y análisis de encuestas. El gran problema que tienen los estadísticos sociales en cómo comunicar sus resultados. El gran arsenal de análisis matemático – estadístico – probabilístico debe traducirse a un lenguaje cotidiano que debe entender una población que desconoce casi por completo el trasfondo técnico de los resultados. El nivel de incertidumbre, la complejidad y diversidad de pensamientos de una población como la de Costa Rica, hacen prácticamente imposible que una muestra tenga capacidad de predicción más allá de unos pocos días y dentro de un contexto limitado.

Una vez presentados los resultados viene la interpretación que hacen los partidos políticos, los medios y el público general. Se escuchan palabras y términos como “tendencia”, “crecimiento exponencial”; se apela a correlaciones incorrectas, se hacen comparaciones sin sentido, y por sobre todo se trata cada número como un valor absoluto, determinístico y final, sin considerar su naturaleza probabilística.

Todos los partidos, sin excepción, perciben que tienen mayores porcentajes de los que las encuestas muestran, y la encuesta sólo es válida si van de primeros. Sucumben ante un fenómeno conocido como el “Efecto Vagón” la tendencia del ser humano a sumarse a la mayoría. Así cada candidato debe presentar una fingida cara de optimismo pues “vamos ganando”, aunque los números digan otra cosa. Otro problema de percepción es el “Sesgo de Confirmación” la tendencia de una persona a utilizar la información que confirma sus ideas, creencias o hipótesis. El candidato ve “el cariño de la gente” a todos los lugares que visita, “la muchedumbre”, que se percibe más grande de lo que realmente es, confirma la victoria inexistente. Los medios terminan de complicar el panorama filtrando toda la información a su disposición (bien o mal analizada, profesional o amateur) y divulgando lo que determine que tendrá mayor impacto mediático.

En conclusión las encuestas de opinión tienen poco valor de predicción en un ambiente complejo con alto grado de incertidumbre. Desde un punto de vista meramente analítico una encuesta debe ser un punto de partida para la aplicación de otras herramientas de mayor valor de predicción.

BAYES Y ANÁLISIS DE “BIG DATA”

Vámonos un momento a la última elección presidencial de los Estados Unidos (2012). La prensa insistía en que era imposible predecir un resultado (too close to call). Ambos partidos juegan con su Efecto Vagón y se declaran ganadores cada vez que una encuesta favorable “brinca” en algún medio. Pasada la elección todos hablan de un resultado sorpresivo, estados que se daban por ganados por un candidato, le dan la victoria al contrario. La prensa habla de la incapacidad de las encuestas para predecir el resultado. Dentro de todo el “análisis” de los medios surge la figura de Nate Silver, un ex consultor de KPMG dedicado a predecir el desempeño de jugadores de beisbol y que hizo cierta fortuna jugando póker). Silver predijo correctamente los resultados de los 50 estados. La verdad es que esto no tiene nada de impresionante, pues es lógico que entre miles y miles de analistas alguien pegara el 100%. Lo impresionante fue descubrir a muchos otros estadísticos que utilizando el mismo sistema llegaron a resultados similares.

El método de Nate Silver es más o menos así. Al inicio de la contienda electoral elegir un grupo de variables que sean realmente importantes como entrada para el modelo de predicción. Las tres variables básicas fueron las siguientes: popularidad de Obama, crecimiento del Producto Interno Bruto, que tan conservador sería el oponente republicano. Todo lo demás eliminarlo. Para saber qué variables escoger estudiar toda la información disponible de elecciones anteriores. Mediante análisis de grandes bases de datos (Big Data) modelar qué ha ganado elecciones hasta la fecha. Cada vez que exista información nueva determinar si es relevante para el modelo. Si la respuesta es no, simplemente no se incluye. Por ejemplo, y parafraseando a Silver, si 25 encuestas de opinión en un estado daban ganador de Barack Obama, y de repente la encuesta número 26, hecha claramente entre personas de perfil republicano, daba por ganador a Mitt Romney, no cambiar la predicción.

Ahora, si hay nueva información relevante, revisar la probabilidad de que cambie el resultado. Si la probabilidad de que haya un cambio de decisión primero crece y luego converge entonces cambiar la predicción. Utilizar Teorema de Bayes, revisar nueva información relevante, y ver el efecto sobre la probabilidad de salida.

En el caso de la elección de Estados Unidos, Silver fue capaz de separar el ruido de los dos partidos y de los medios de comunicación, y lograr una predicción convincente. La primera iteración del 7 de Junio del 2012 predecía una probabilidad de 0.618 de que Obama ganara mayoría en el Colegio Electoral. Basado en nueva información relevante (Big Data) y mediante Teorema de Bayes la última predicción, el 6 de Noviembre del 2012 indicaba 90.9% de probabilidad a favor de Obama.

Diseñe su modelo de predicción, aliméntelo con todos los datos relevantes disponibles pasados y presentes. Utilice las encuestas como puntos de partida arbitrarios (no como resultados ciertos) y modifique su análisis por medio de Teorema de Bayes cuando los nuevos datos (grandes datos si es posible) así lo indiquen.

Viene segunda ronda electoral en Costa Rica. Gran error cometerían los partidos si nuevamente utilizan las encuestas como forma única de predicción.

Hacer predicciones acertadas es muy difícil, ya sea en elecciones presidenciales o en pronósticos de negocios. El escritor rumano del género teatral del Absurdo Eugène Ionesco decía “solamente se pueden predecir las cosas después de que pasan”. Pero hacer predicciones es necesario para planear, estimar recursos, generar presupuestos, etc. No nos quedemos solamente con información parcial (las encuestas, el comportamiento histórico de la demanda) y agreguemos todas las herramientas que estén a nuestro alcance, en este caso “Big Data” y Teorema de Bayes para mejorar nuestra capacidad de predicción en un mundo complejo y lleno de ruido.